Nightshade - новый инструмент борьбы художников против генеративного ИИ

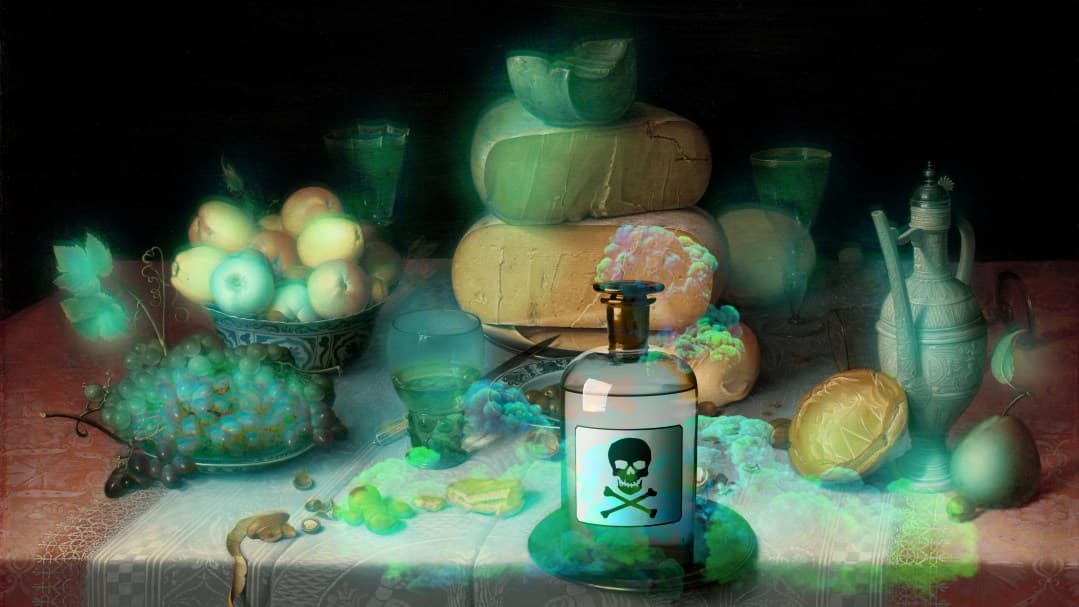

Новый инструмент под названием Nightshade позволяет художникам вносить невидимые изменения в пиксели своих произведений перед их публикацией в интернете. Если такие изображения попадут в обучающие наборы данных ИИ, они могут вызвать серьезные сбои в работе моделей генерации изображений, таких как DALL-E, Midjourney и Stable Diffusion, делая некоторые результаты их работы бесполезными.

Инструмент был создан как способ борьбы против компаний, которые используют работы художников для обучения своих моделей без разрешения авторов. Использование Nightshade для "отравления" обучающих данных может повредить будущие итерации моделей генеративного ИИ, превращая, например, собак в кошек, автомобили в коров и так далее.

Компании, занимающиеся ИИ, такие как OpenAI, Meta, Google и Stability AI, столкнулись с рядом исков от художников, которые утверждают, что их авторские материалы и личная информация были собраны без согласия и компенсации. Бен Чжао, профессор из Университета Чикаго, который возглавил команду, создавшую Nightshade, надеется, что это поможет вернуть баланс сил от компаний ИИ в сторону художников.

Команда Чжао также разработала инструмент Glaze, который позволяет художникам "маскировать" свой собственный стиль, чтобы предотвратить его копирование компаниями ИИ. Он работает аналогично Nightshade, изменяя пиксели изображений незаметными способами, которые вводят в заблуждение модели машинного обучения.

Nightshade будет интегрирован в Glaze, и художники смогут выбирать, использовать ли им инструмент отравления данных. Команда также планирует сделать Nightshade открытым исходным кодом, что позволит другим модифицировать его и создавать собственные версии. Чем больше людей будет использовать его и создавать свои версии, тем мощнее станет инструмент.

Nightshade использует уязвимость в моделях генеративного ИИ, возникающую из-за того, что они обучены на огромном количестве данных, в данном случае изображений, собранных из интернета. Художники, которые хотят загружать свои работы в интернет, но не хотят, чтобы их изображения собирались компаниями ИИ, могут загрузить их в Glaze и выбрать маскировку под другой художественный стиль. Затем они также могут выбрать использование Nightshade. Как только разработчики ИИ начнут собирать данные из интернета для корректировки существующей модели ИИ или создания новой, эти "отравленные" образцы попадут в набор данных модели и вызовут ее сбой.

Исследователи протестировали атаку на последних моделях Stable Diffusion и на модели ИИ, которую они обучили с нуля. Когда они подали Stable Diffusion всего 50 отравленных изображений собак и затем попросили его создать изображения собак, результаты начали выглядеть странно — существа с избыточным количеством конечностей и мультяшными лицами. С 300 отравленными образцами атакующий может манипулировать Stable Diffusion так, чтобы он генерировал изображения собак, похожих на кошек.

Художники, такие как Ева Торенент и Отамн Беверли, выразили надежду, что инструменты вроде Nightshade и Glaze дадут им уверенность снова публиковать свои работы в интернете. Они ранее удаляли свои работы из интернета после того, как обнаружили, что они были собраны без их согласия в популярную базу данных изображений LAION.

"Я просто очень благодарна за то, что у нас есть инструмент, который может помочь вернуть художникам контроль над их собственными работами", — говорит Беверли.