Технология дипфейк — обоюдоострый меч инноваций

Технология дипфейков (deepfake) возникла благодаря достижениям в области искусственного интеллекта и машинного обучения, позволяя создавать высокореалистичные видео- и аудиоклипы, в которых люди говорят или делают то, чего они на самом деле не делали.

Несмотря на значительный потенциал для положительного применения в различных отраслях, дипфейки создают серьезные этические проблемы, проблемы конфиденциальности и безопасности, включая распространение дезинформации, политические манипуляции и личные преследования.

В этой статье мы исследуем технологию deepfake, рассмотрим лежащие в ее основе механизмы, области применения и этические последствия. Обсудим развитие сложных алгоритмов искусственного интеллекта, в частности генеративных состязательных сетей (GAN), и их способность создавать убедительно реальный медиаконтент.

Анализ показывает сложный ландшафт, в котором потенциал технологии deepfake сочетается с ее способностью наносить вред, в частности подрывать доверие к СМИ, влиять на общественное мнение и нарушать неприкосновенность частной жизни.

Чтобы использовать преимущества и одновременно снизить риски, необходима многогранная стратегия, сочетающая технологические, правовые и этические основы. Это включает в себя разработку передовых методов обнаружения, установление четких правовых стандартов и разработку этических принципов, регулирующих использование и распространение фейкового контента.

Введение

В последние годы технология deepfake стала одной из самых спорных и обсуждаемых инноваций в области искусственного интеллекта (ИИ). Она предполагает использование сложных алгоритмов ИИ, в частности генеративных состязательных сетей (GAN), для создания или манипулирования аудио- и видеозаписями, чтобы они выглядели достоверно естественными. Несмотря на то что технология обладает значительным потенциалом для положительного применения, она создает серьезные этические, правовые и социальные проблемы.

В мире deepfake видеть - уже не значит верить; для распознавания истины требуется более глубокий взгляд.

Технология дипфейков — это использование искусственного интеллекта (ИИ) и алгоритмов машинного обучения для создания или изменения видео- и аудиозаписей с целью создать впечатление, что человек говорит или делает то, чего он на самом деле не говорил и не делал. Эта технология часто использует глубокое обучение, в частности генеративные состязательные сети (GAN), чтобы манипулировать или генерировать визуальный и аудиоконтент с высокой степенью реализма.

Дипфейки имеют различные применения, в том числе в индустрии развлечений, для создания реалистичных эффектов в фильмах и видеоиграх, или в образовательных целях, например, для моделирования исторических событий. Однако они также вызывают серьезные этические и юридические проблемы, особенно в отношении согласия, конфиденциальности и возможности использования для распространения дезинформации, совершения мошенничества или нанесения ущерба репутации.

Качество дипфейков быстро улучшается, что делает все более сложным различение реального и манипулируемого контента. Это привело к разработке методов обнаружения и нормативных актов для борьбы с вредоносным использованием, подчеркивая необходимость осознания и критической оценки медиаконтента.

Механизм работы технологии дипфейк

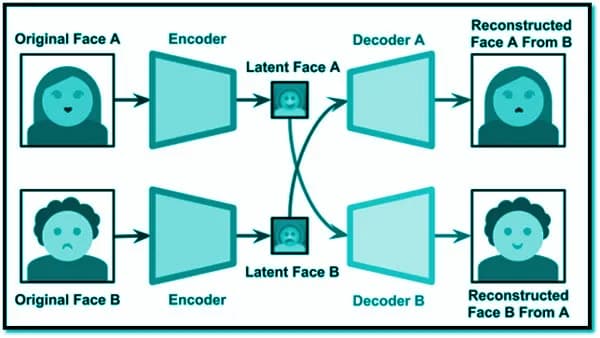

Технология дипфейк работает путем обучения модели машинного обучения на наборе данных изображений или видеозаписей целевого человека. ИИ учится распознавать паттерны, особенности и нюансы внешности и поведения объекта. Используя эти знания, он может генерировать или изменять контент, создавая убедительно реалистичные изображения или видео, на которых субъект говорит или делает то, чего он на самом деле не делал. Реалистичность дипфейков достигла такого уровня, что их сложно отличить от настоящих записей, что требует применения передовых методов обнаружения.

Области применения дипфейков

Сферы применения технологии дипфейков разнообразны — от безвредных до потенциально опасных. В индустрии развлечений дипфейки используются для омоложения актеров, воскрешения умерших личностей для выступлений и улучшения спецэффектов. Дипфейки могут оживлять исторических личностей в области образования, обеспечивая погружение в процесс обучения. Кроме того, они могут быть использованы в персонализации и виртуальной реальности, предлагая создание реалистичных аватаров и окружения.

Этические и юридические последствия

Рост числа дипфейков вызывает серьезные этические и юридические проблемы. Потенциал злоупотреблений огромен, включая создание фейковых новостей, которые могут подорвать доверие к СМИ, повлиять на выборы и вызвать общественную панику. Кроме того, дипфеки создают серьезные проблемы с конфиденциальностью, поскольку сходство людей может быть использовано без их разрешения, что может привести к диффамации, кибербуллингу и другим формам преследования.

Борьба с неправомерным использованием подделок

Решение проблем, создаваемых технологией deepfake, требует многогранного подхода. Многогранность заключается в разработке методов обнаружения, позволяющих отличить реальный контент от фальшивого. К ним относятся модели машинного обучения, анализирующие несоответствия или артефакты в видео. Кроме того, для определения и соблюдения этических норм использования технологии deepfake, защиты прав человека и обеспечения ответственности за неправомерное использование необходимы правовые и регулятивные меры.

Код

Создание полной системы дипфейков в одном блоке кода — сложная задача, учитывая тонкости моделей глубокого обучения, подготовки данных, обучения и оценки. Приведем упрощенный пример, иллюстрирующий основные компоненты такой системы. В этом примере не будут создаваться настоящие дипфеки, но будет продемонстрирован процесс обучения модели на синтетическом наборе данных, выполнения инженерии признаков, оценки модели и построения графика результатов.

Вот гипотетический блок кода, который описывает эти шаги на Python с использованием библиотек машинного обучения TensorFlow и scikit-learn:

import numpy as np

import matplotlib.pyplot as plt

from sklearn.model_selection import train_test_split

from tensorflow.keras import layers, models, optimizers

# Создание синтетического набора данных (это просто иллюстрация, а не реальные данные изображений)

def create_synthetic_data(samples=1000, image_size=(64, 64, 3)):

X = np.random.randn(samples, *image_size)

y = np.random.randint(0, 2, samples) # Бинарные метки для простоты

return X, y

# Инжиниринг признаков (в данном случае простая нормализация)

def preprocess_data(X):

return X / 255.0

# Построение модели (простая CNN для иллюстрации)

def build_model(input_shape):

model = models.Sequential([

layers.Conv2D(32, (3, 3), activation='relu', input_shape=input_shape),

layers.MaxPooling2D((2, 2)),

layers.Conv2D(64, (3, 3), activation='relu'),

layers.MaxPooling2D((2, 2)),

layers.Conv2D(64, (3, 3), activation='relu'),

layers.Flatten(),

layers.Dense(64, activation='relu'),

layers.Dense(1, activation='sigmoid')

])

model.compile(optimizer='adam',

loss='binary_crossentropy',

metrics=['accuracy'])

return model

# Основная программа

if __name__ == "__main__":

X, y = create_synthetic_data()

X = preprocess_data(X)

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2)

model = build_model(X_train.shape[1:])

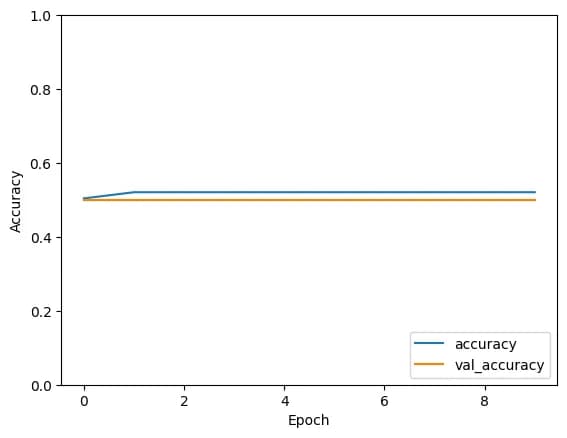

history = model.fit(X_train, y_train, epochs=10, validation_split=0.1)

# Отображение истории обучения

plt.plot(history.history['accuracy'], label='accuracy')

plt.plot(history.history['val_accuracy'], label='val_accuracy')

plt.xlabel('Epoch')

plt.ylabel('Accuracy')

plt.ylim([0, 1])

plt.legend(loc='lower right')

# Оценка модели

test_loss, test_accuracy = model.evaluate(X_test, y_test, verbose=2)

print(f"Test accuracy: {test_accuracy}")

# Интерпретации и выводы можно сделать на основе test_accuracy,

# кривых потерь и других метрик по мере необходимости.

Данный код является упрощенной иллюстрацией процесса и не представляет собой функциональный генератор deepfake. Создание deepfake включает в себя сложные процедуры, в том числе обучение GAN на больших и специфических наборах данных, что требует значительных вычислительных ресурсов и опыта машинного обучения и компьютерного зрения.

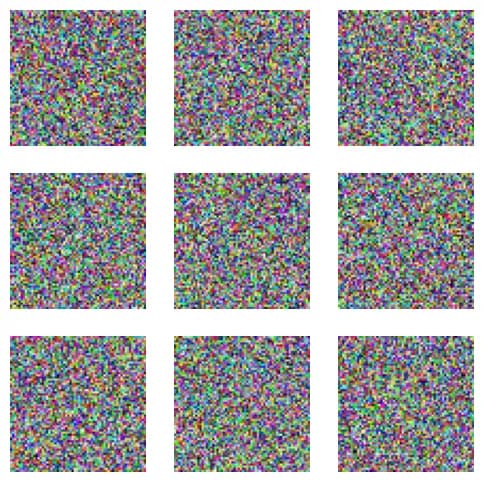

Чтобы построить график изображений из синтетического набора данных, нам нужно сгенерировать несколько примеров изображений, а затем отобразить их с помощью библиотеки построения графиков, например matplotlib. Вот как создать простые синтетические изображения и отобразить их:

import matplotlib.pyplot as plt

import numpy as np

# Генерация синтетических изображений

def generate_images(num_images, size=(64, 64, 3)):

return np.random.rand(num_images, *size)

# Отображение изображений

def plot_images(images, rows, cols):

fig, axes = plt.subplots(rows, cols, figsize=(cols * 2, rows * 2))

for i, ax in enumerate(axes.flat):

if i < len(images):

ax.imshow(images[i])

ax.axis('off')

plt.show()

# Генерация и отображение изображений

num_images = 9

images = generate_images(num_images)

plot_images(images, 3, 3)

В этом коде:

- Функция

generate_imagesсоздает набор синтетических изображений, представленных в виде массивов NumPy. Каждое "изображение" - это просто массив случайных значений пикселей. - Функция

plot_imagesпринимает эти изображения и отображает их в сетке с указанными строками и столбцами с использованием matplotlib.

Этот пример генерирует и отображает случайные шумовые изображения, чтобы продемонстрировать, как может работать отображение изображений в Python. Для реальных изображений дипфейков требуется более сложный процесс генерации с участием обученных моделей нейронных сетей.

Заключение

Технология дипфейков олицетворяет двойственную природу технологического прогресса, предлагая удивительные возможности и серьезные вызовы. Хотя она может стимулировать инновации и создавать новые формы развлечений и образования, она также требует осторожного подхода для снижения рисков. Будущее технологии дипфейков будет в значительной степени зависеть от баланса между использованием ее потенциала для положительного воздействия и эффективным управлением рисками с помощью этических принципов, технологических гарантий и правовых рамок. Общество должно быть бдительным и проактивным в навигации по этому сложному ландшафту, чтобы технология дипфейков служила общему благу, а не подрывала его.