Какова ценность данных в эпоху генеративного ИИ?

Reddit, который еще в октябре грозился заблокировать доступ Google к своим страницам, теперь принял предложение от компании, занимающейся разработкой алгоритмов ИИ, которая хочет использовать контент сайта социальных новостей для обучения своих моделей. Тем временем, Apple и OpenAI продолжают предлагать крупным СМИ многомиллионные сделки за доступ к их новостям. Все это поднимает очень интересный вопрос: сколько стоят данные, где они находятся и как их можно монетизировать?

Недавний взрывной рост генеративного ИИ основан на ключевом решении компаний, разрабатывающих его, принятом без особых раздумий: вместо обучения алгоритмов на конкретных наборах данных, они просто прочесывали информацию из сети. Решения против владельцев сайтов, таких как LinkedIn, которые, казалось бы, указывали на то, что если данные публикуются открыто, их можно собирать методом веб-скрапинга и использовать свободно, противоречили решениям в отношении таких компаний, как Clearview, которые явно злоупотребляли этой практикой и создавали явный кошмар в плане конфиденциальности.

Очевидно, решение прочесать интернет подняло еще одну проблему: надежность. Если используемые данные полны теорий заговора, экстремистских взглядов или прочего бреда, их ценность при использовании для обучения алгоритмов значительно снижается, потому что требуется использование дорогостоящих систем мониторинга для фильтрации вредного контента.

Поставщики данных, которые установили процессы обеспечения качества, кажется, имеют преимущество. Но преимущество могут иметь и те, кто генерировал данные, связанные, например, с системами социального рейтинга, которые отбирали лучший контент и отделяли его от контента более низкого качества, при условии, что эти данные были помечены достаточно последовательными онтологиями, позволяющими навести какой-то порядок в хаосе.

После начальной стадии Дикого Запада, в течение которой компании, разрабатывающие ИИ, использовали все, до чего могли добраться, легально или нелегально, для обучения своих алгоритмов, наступила вторая стадия, породившая жалобы всех видов. Внезапно художники, писатели, комедианты или репозиторий изображений Getty Images, предупрежденные появлением материала, очень похожего на их собственный, часто с ухудшенными версиями на нем их водяного знака, начали подавать в суд на эти компании, доведя их до пересмотра жизнеспособности их бизнес-модели. Авторское право снова атаковало: у нас была возможность создавать ИИ с впечатляющими способностями, но владельцы контента, использованного для их обучения, хотели свою долю.

С каждым новым алгоритмом вновь возникает ключевой вопрос: чьи данные были использованы для его обучения? Тем временем, компании-разработчики алгоритмов утверждают, что любой мог пройтись по музею, вдохновиться искусством конкретного художника и, если позволяют навыки, создать похожие работы, не платя никому. Но аргумент по сравнению с фактом взлома страницы и извлечения тысяч кусков информации с помощью автоматизированной процедуры был мягко говоря слаб; что приводит нас к настоящему моменту: в стремлении избежать судебных исков все больше компаний, разрабатывающих генеративные алгоритмы, заключают сделки со всеми, у кого могут быть полезные данные.

Каким критериям должны соответствовать эти данные, чтобы их можно было использовать для обучения алгоритмов?

-

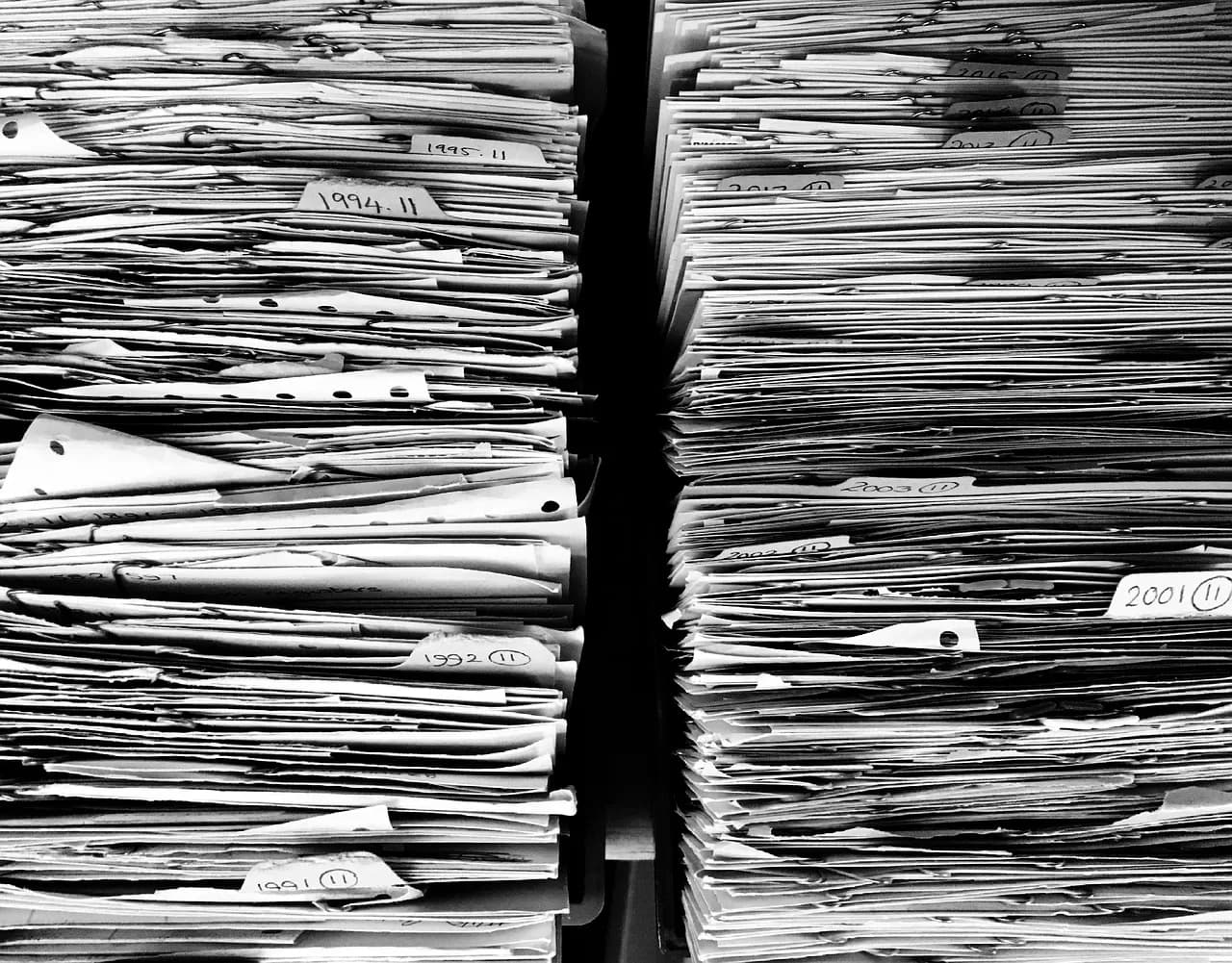

Объем: очевидно, что для того, чтобы быть хоть сколько-нибудь полезной, коллекция данных должна быть достаточно большой. Чем больше размер, при условии выполнения других переменных, тем больше ценность. Если речь идет еще и об актуальных источниках, то есть источниках, которые продолжают последовательно обновляться, ценность будет больше, чем у архивов.

-

Качество: репозиторий данных, полный информации, которая снижает его ценность, будь то экстремистский или нежелательный контент, низкое качество по другим причинам (плохо написанный, с ошибками или концептуальными ошибками), малополезен, потому что его нужно очищать вручную. Качество контента, с другой стороны, может исходить либо от авторитетности его источника, либо от наличия систем социального рейтинга, позволяющих фильтровать контент по его качеству, хотя и с определенными ограничениями. Пример ясен: данные Quora, безусловно, могут быть очень ценными, но будут ли данные с сервиса вроде Yahoo! Answers стоить многого? Скорее всего, нет.

-

Теги: наличие последовательных систем тегирования, позволяющих организованный или систематический доступ к контенту, имеет фундаментальное значение для его ценности для обучения алгоритмов. Опять же, если такие системы отсутствуют, их нужно делать вручную или с помощью извлечения ключевых слов, что делает их использование более дорогим.

-

Тематика: некоторые области могут быть более интересными, чем другие.

-

Последовательность: последовательная коллекция данных, то есть коллекция, которая подчиняется разумным и, что важно, познаваемым критериям однородности, более ценна, чем та, в которой есть значительные различия в распределении ее переменных.

-

Нормальность: в целом, репозитории данных, в которых сгенерированные векторы ближе к нормальному распределению, могут быть более ценными, чем те, которые по тем или иным причинам сильно смещены.

-

Лицензия: влияет ли тип лицензии на ценность данных? Возможно, нет, поскольку за исключением данных, лицензированных в общественное достояние, которые можно использовать свободно, даже наименее ограничительные лицензии, такие как указание авторства, систематически нарушаются алгоритмами, которые на протяжении всего процесса обучения претерпевают многочисленные преобразования и теряют отслеживаемость используемых данных, так что их способность осуществлять атрибуцию, позволяющую соблюдать условия лицензии, кажется сомнительной, мягко говоря.

Кому принадлежат эти репозитории данных? Какую ценность может иметь возможность обучать алгоритмы с их помощью? Являются ли данные цифровым золотом 21 века?